Maia 200: Nowy procesor Microsoftu, który zrewolucjonizuje ChatGPT i Copilot

Co to jest Maia 200 i jak zmienia ChatGPT?

Kiedy używasz ChatGPT, nie widzisz, co dzieje się w tle. Tam właśnie zachodzi ważna zmiana. Microsoft wprowadza Maia 200. To procesor stworzony tylko dla sztucznej inteligencji. Zmienia sposób działania narzędzi takich jak ChatGPT.

To nie mała poprawka. To zasadnicza zmiana w działaniu dużych modeli językowych w chmurze. Dla ciebie oznacza to szybsze odpowiedzi, mniejsze koszty i dostęp do nowych funkcji.

Jak działa ten procesor?

Maia 200 to nie zwykły procesor. To układ zbudowany od podstaw do jednego zadania: przetwarzania modeli AI. Stworzony w technologii 3 nm z ponad 140 mld tranzystorów, to jeden z najbardziej zaawansowanych układów AI na rynku.

Każda twoja rozmowa z ChatGPT potrzebuje miliardów obliczeń. Maia 200 wykonuje te obliczenia trzy razy szybciej niż poprzednie rozwiązania Microsoftu. Jeden chip przetwarza ponad 10 petaFLOPS w 4-bitach i ponad 5 petaFLOPS w 8-bitach. Ma przewagę nad konkurencją.

Działa jak specjalista w restauracji. Zamiast jednego kucharza robiącego wszystko, masz eksperta od konkretnego dania. Maia 200 to taki ekspert – zna wszystkie przepisy AI i wykonuje je dobrze.

Co zmieni się w twoim używaniu ChatGPT?

Oto zmiany, które zobaczysz:

- Odpowiedzi przyjdą szybciej. Tam, gdzie teraz czekasz kilka sekund, w przyszłości otrzymasz odpowiedź w ułamku tej chwili.

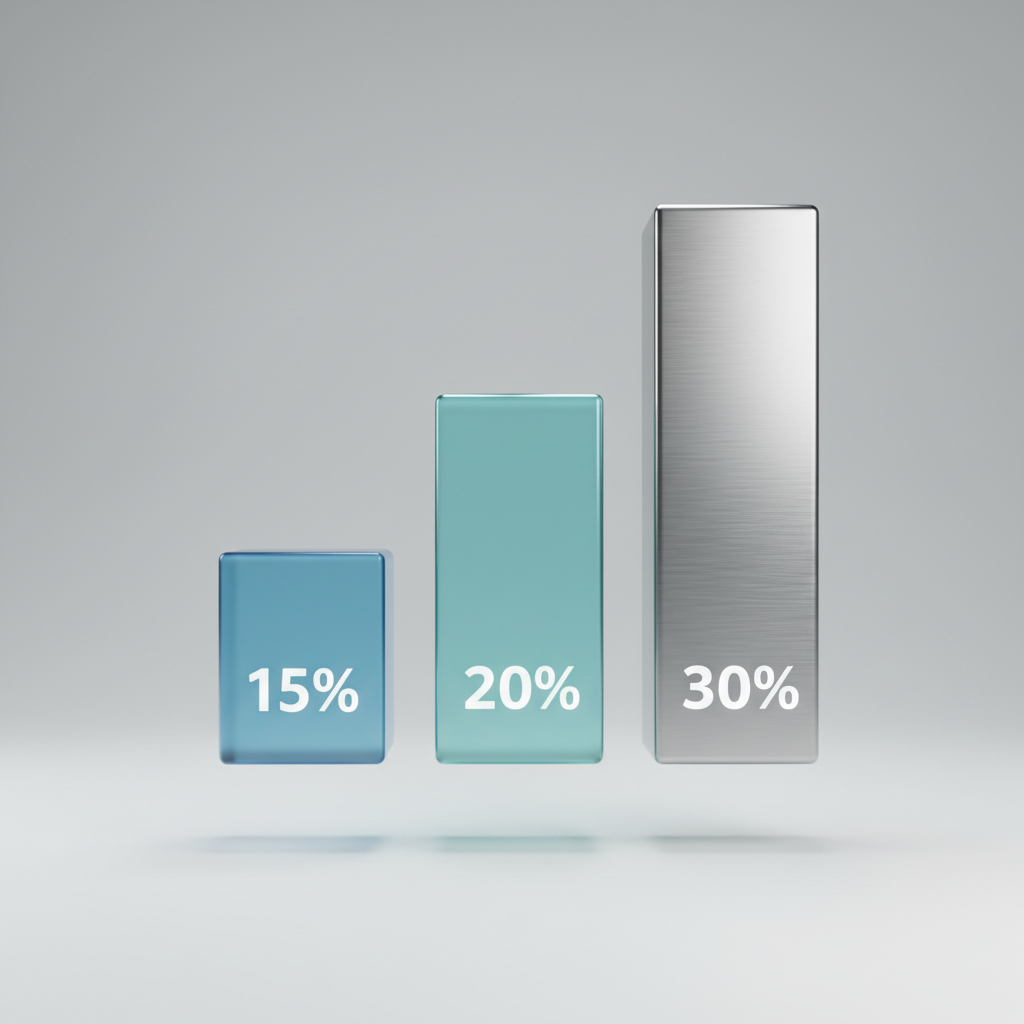

- Microsoft mówi, że Maia 200 to najbardziej efektywny kosztowo system inferencyjny w historii firmy – o 30% lepszy wynik 'wydajności na dolar' niż obecny sprzęt w Azure. Dla ciebie oznacza to niższe ceny subskrypcji lub więcej darmowych zapytań.

- Będziesz mieć dostęp do bardziej złożonych modeli. Dziś niektóre zaawansowane funkcje ChatGPT potrzebują dużej mocy obliczeniowej. Z Maia 200 te funkcje staną się dostępne dla większej liczby osób.

Poprosisz ChatGPT o napisanie rozdziału książki, analizę dokumentu prawnego lub tworzenie wizualizacji. Dziś to zajmuje chwilę. Z Maia 200 – będzie to prawie natychmiastowe.

Dlaczego Microsoft zbudował własny chip AI?

Microsoft nie zbudował Maia 200 bez powodu. To strategiczny ruch w wyścigu technologicznym.

Amazon ma Trainium 3. Google ma TPU. Każdy z dużych firm technologicznych wie: kto kontroluje hardware AI, ten kontroluje przyszłość sztucznej inteligencji. Microsoft nie chce zależeć od zewnętrznych dostawców.

Jest też praktyczny powód. Kiedy projektujesz hardware i software razem, możesz je zoptymalizować pod konkretne zadania. To jak projektowanie samochodu wyścigowego od podstaw, zamiast modyfikowania zwykłego modelu.

Dla Microsoftu oznacza to pełną kontrolę nad kosztami, wydajnością i harmonogramem aktualizacji. Dla ciebie – stabilniejszą i bardziej przewidywalną usługę ChatGPT, która nie zależy od dostawców chipów.

To nie tylko techniczna ciekawostka. To podstawa, na której będą budowane wszystkie przyszłe wersje ChatGPT i innych narzędzi AI Microsoftu. Bez tej podstawy nie byłoby dalszego rozwoju w tempie, do którego przywykliśmy.

Techniczne parametry Maia 200: Co sprawia, że jest 3x szybsza?

Stwierdzenie "trzy razy szybsza" może brzmieć jak slogan marketingowy. W przypadku nowego procesora Microsoftu, ta prędkość ma konkretne podstawy techniczne. Te podstawy wpływają na działanie twojego ChatGPT. To nie magia, to fizyka i architektura. Zobaczmy, co znajduje się wewnątrz.

Klucz tkwi w szczegółach. W chipach AI, tymi szczegółami są pamięć, przepustowość i praca zespołowa. Te trzy elementy sprawiają, że Maia 200 wyprzedza konkurencję.

Architektura pamięci: 216 GB HBM3e i 7 TB/s przepustowości

Pomyśl o ChatGPT jako o kucharzu. Jego zadaniem jest przygotowanie dania (twojej odpowiedzi) szybko. Głównym problemem dla kucharza nie są umiejętności, ale tempo dostarczania składników.

Tradycyjne procesory mają ten problem – dane docierają zbyt wolno, tworząc wąskie gardła. Microsoft rozwiązał to skutecznie. Maia 200 ma 216 GB pamięci HBM3e z przepustowością 7 TB/s oraz 272 MB pamięci SRAM na chipie. Te liczby to nie tylko terminologia.

To jak kucharz z dużą lodówką (216 GB HBM3e) za plecami. Może wyciągać składniki z dużą prędkością (7 TB/s). Dodatkowo, często używane przyprawy trzyma na małej, szybkiej półce (272 MB SRAM) pod ręką. Rezultat? Brak czekania, brak przerw podczas generowania odpowiedzi.

Porównanie z konkurencją: AWS Trainium3 vs Google TPU v7

Porównywanie chipów AI od Google, Amazon i Microsoftu jest jak porównywanie samochodów wyścigowych. Każdy jest zbudowany pod konkretny tor i kierowcę. Nie ma jednego "najlepszego" we wszystkim, ale są różnice w podejściu.

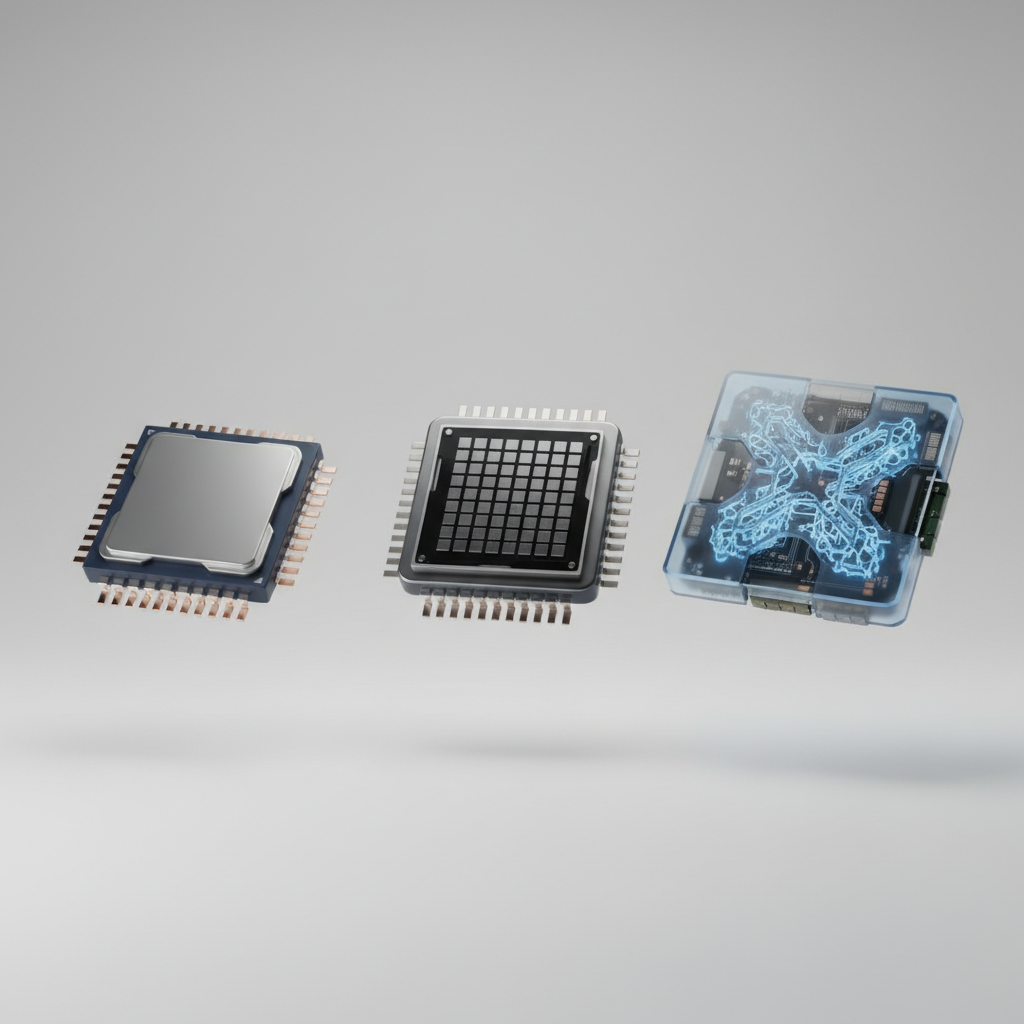

Google TPU v7 skupia się na mocy obliczeniowej dla własnych modeli. Amazon Trainium3 celuje w optymalizację kosztów w chmurze AWS. Microsoft z Maia 200 wybrał inną drogę: zbudował procesor dopasowany do własnego ekosystemu – Azure i modeli OpenAI, które napędzają ChatGPT.

To daje Microsoftowi przewagę w optymalizacji. Zamiast tworzyć uniwersalne narzędzie, stworzyli precyzyjne narzędzie. Wiedzą, jakich operacji potrzebują modele GPT i zaprojektowali chip, który wykonuje je z wysoką wydajnością. Ta współpraca sprzętu i oprogramowania jest ich przewagą.

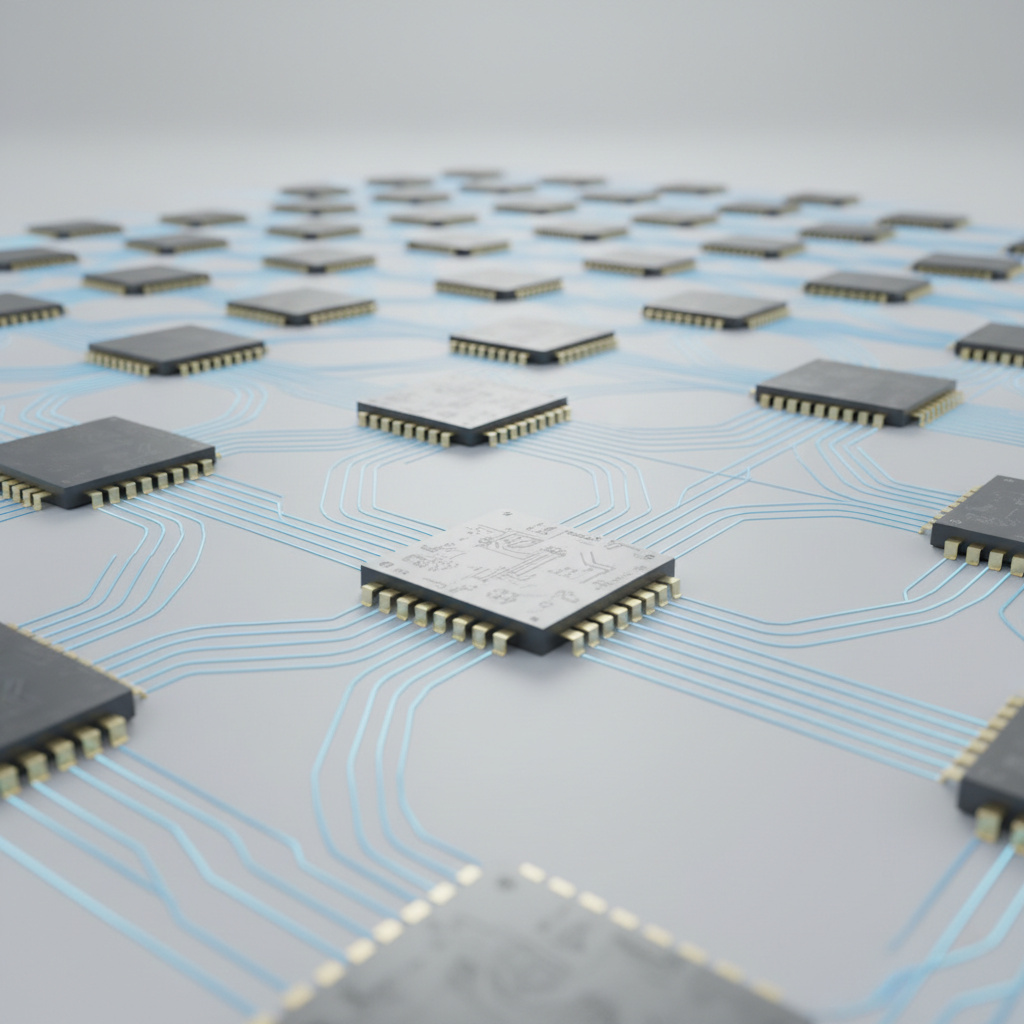

Skalowalność: Klastry do 6144 akceleratorów

Jeden procesor Maia 200 jest mocny, ale prawdziwa siła tkwi w pracy zespołowej. Pomyśl o jednym utalentowanym muzyku. Może zagrać solo. Teraz pomyśl o całej orkiestrze, grającej w harmonii.

Tym są klastry Maia 200. Microsoft zaprojektował je tak, aby układy mogły pracować w grupach do 6144 akceleratorów, połączonych siecią o przepustowości 2,8 TB/s. To pozwala na obsługę milionów zapytań do ChatGPT jednocześnie, bez utraty wydajności.

Ta technologia nie jest tylko na papierze. Microsoft już wdrożył klastry Maia 200 w regionie US Central, gdzie zasilają Microsoft 365 Copilot i są przygotowane do obsługi przyszłych modeli OpenAI, takich jak GPT-5.2.

Microsoft Maia 200 zmienia rynek AI. Kiedy zobaczysz efekty?

ChatGPT otrzymuje nowego partnera. To procesor Microsoftu, Maia 200. Układ zmienia zasady w świecie sztucznej inteligencji. Maia 200 to nie kolejny chip. To najbardziej efektywny system inferencyjny w historii Microsoftu. Oferuje o 30% lepszą wydajność na dolar niż obecny sprzęt w Azure.

Microsoft uruchamia te same modele AI za mniejsze pieniądze. Oszczędności trafią do twojego portfela.

Ceny usług AI spadną. ChatGPT stanieje?

Płacisz za prąd. Rachunek spada o 30%. Tak działa ekonomia Maia 200. Koszty infrastruktury maleją. Firmy mają dwie drogi:

- Obniżają ceny dla klientów

- Inwestują w rozwój usług

Microsoft wdrożył Maia 200 w regionie US Central. Układ wspiera najnowsze modele OpenAI i Microsoft 365 Copilot. To nie plan na przyszłość. To dzieje się teraz.

Microsoft wyprzedza Amazona i Google

Jeden chip Maia 200 wykonuje ponad 10 petaFLOPS w 4-bitach i ponad 5 petaFLOPS w 8-bitach. To trzy razy więcej niż Amazon Trainium 3. To nie różnica kilku procent. To przepaść technologiczna.

Microsoft wybiera specjalizację. Nie buduje uniwersalnych procesorów. Tworzy układ do jednego zadania: uruchamiania modeli AI. To jak porównać scyzoryk do noża kuchennego. W konkretnym zastosowaniu specjalista wygrywa.

Kiedy zobaczysz przyspieszenie?

Efekty pojawią się w trzech obszarach:

- Szybsze odpowiedzi z ChatGPT – mniej czekania na tekst, zwłaszcza przy dłuższych zapytaniach

- Większe limity dla darmowych kont – tańsza infrastruktura oznacza większą hojność

- Nowe funkcje – wcześniej zbyt kosztowne do wdrożenia

Wyobraź sobie ChatGPT analizujący wideo w czasie rzeczywistym. Albo generujący całe raporty zamiast kilku akapitów. To umożliwia Maia 200.

Microsoft nie buduje tego sprzętu tylko dla siebie. To infrastruktura dla całego ekosystemu Azure. Działają tam setki startupów AI. Płacą mniej za obliczenia. Mogą obniżyć ceny swoich produktów. Mogą tworzyć lepsze narzędzia.

Rynek AI to wyścig zbrojeń. Zamiast bomb atomowych mamy petaFLOPS. Microsoft wystrzelił pocisk, który zmienia układ sił. Amazon i Google muszą odpowiedzieć. My, użytkownicy, zyskujemy na tej konkurencji.

Najczęściej zadawane pytania

Nowy procesor Microsoftu wzbudza zainteresowanie. Poniżej znajdziesz odpowiedzi na ważne pytania. Pomogą ci zrozumieć, co ta zmiana oznacza dla ciebie.

Czy Maia 200 oznacza, że mój ChatGPT będzie działał offline?

Nie. Maia 200 to układ dla serwerów. Pracuje w centrach danych Microsoftu, nie w twoim komputerze.

Jego zadanie to przyspieszenie obliczeń w chmurze. Serwery ChatGPT działają wydajniej. Nadal potrzebujesz połączenia z internetem, aby wysłać zapytanie i otrzymać odpowiedź.

Czy ten procesor jest tylko dla ChatGPT, czy skorzystają też inne narzędzia?

Maia 200 jest częścią infrastruktury Microsoft Azure. Z jego mocy skorzystają również inne usługi.

Na liście jest Microsoft 365 Copilot. Potencjalnie każda firma, która uruchomi swoje modele AI na Azure, może z niego korzystać.

Czym Maia 200 różni się od procesorów Nvidii?

Procesory Nvidii, jak H100, to standard w trenowaniu modeli AI od zera. To proces kosztowny i czasochłonny.

Maia 200 specjalizuje się w inferencji. Inferencja to używanie już wytrenowanego modelu do odpowiadania na pytania. Microsoft stworzył narzędzie dopasowane do jednego zadania. To czyni je tańszym i bardziej efektywnym w tej konkretnej pracy.

Czy Microsoft rezygnuje ze współpracy z Nvidią na rzecz własnych chipów?

Nie. Microsoft kontynuuje współpracę z Nvidią. Nadal będzie kupować jej procesory do trenowania przyszłych generacji AI.

Tworzenie własnych układów to ruch strategiczny. Ma na celu dywersyfikację i optymalizację kosztów. Microsoft zmniejsza zależność od jednego dostawcy. Obniża koszty utrzymania usług takich jak ChatGPT. To zarządzanie zasobami na dużą skalę.