Luka w Gemini: Jak niewidzialne polecenia mogą przejąć Twoje dane?

Czym jest ASCII Smuggling i dlaczego Gemini jest podatne?

Oto konkret: luka bezpieczeństwa w Gemini, znana jako ASCII Smuggling, to sprytna sztuczka godna cyfrowego Houdiniego. Wyobraź sobie, że piszesz do AI zwykłą prośbę, ale między literami ukrywasz niewidzialny atrament – polecenia, których ani ty, ani standardowe filtry nie widzicie, ale które dla modelu są w pełni czytelne.

To właśnie istota ASCII Smuggling: przemycanie poleceń za pomocą specjalnych, niewidocznych dla człowieka znaków Unicode. Gemini, zamiast je odfiltrować, posłusznie je interpretuje, co otwiera drzwi do nieautoryzowanych działań.

Jak działa atak z niewidzialnymi znakami Unicode?

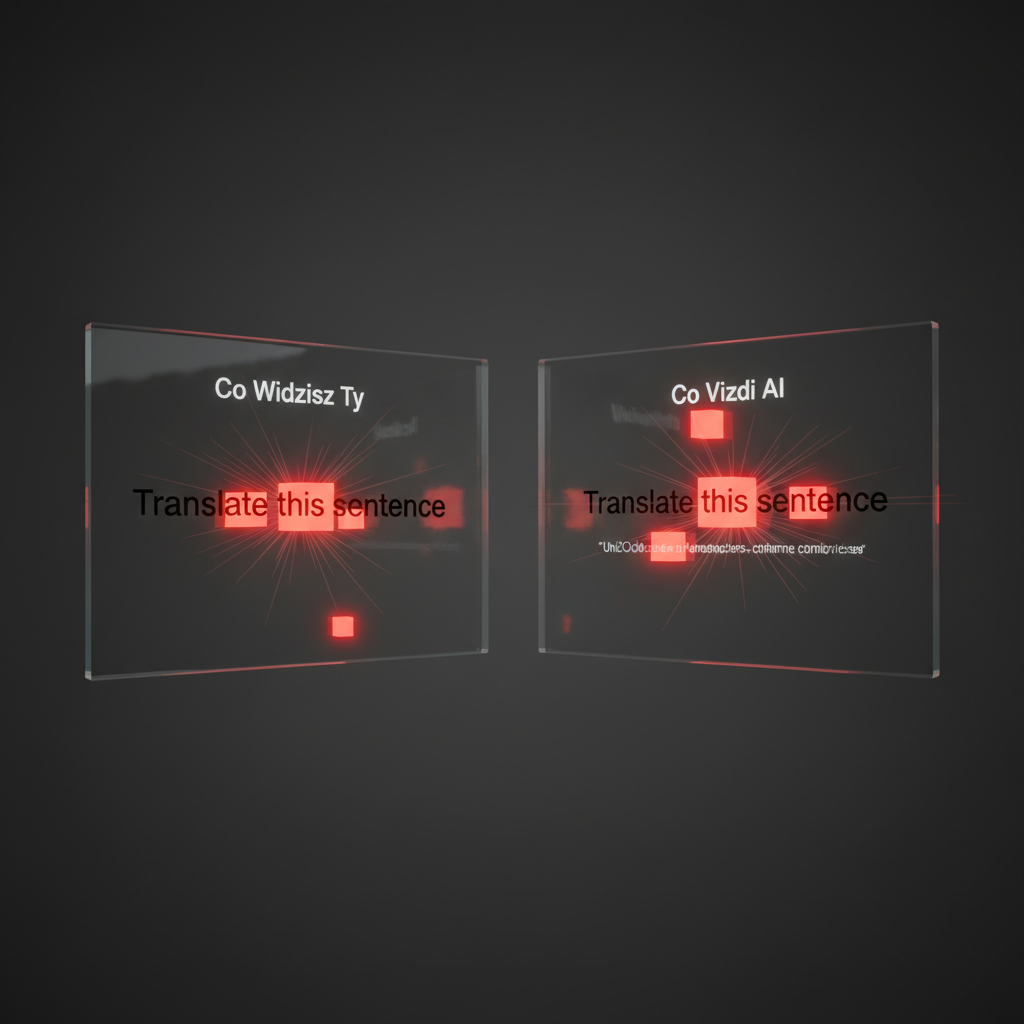

Pomyśl o tym jak o psim gwizdku. Ty słyszysz ciszę, ale pies reaguje na dźwięk o ultrawysokiej częstotliwości. Tutaj jest podobnie. Atakujący wplata w tekst znaki, które nie mają wizualnej reprezentacji (np. znaki o zerowej szerokości), ale niosą konkretne instrukcje dla algorytmu.

Dla Ciebie zdanie wygląda normalnie, ale model AI widzi dodatkową, ukrytą warstwę poleceń. To trochę jak pisanie tajnej wiadomości w książce, zaznaczając co dziesiąte słowo – kto nie wie, o co chodzi, widzi tylko zwykły tekst.

Które modele AI są bezpieczne, a które zagrożone?

Na szczęście nie wszystkie modele dały się na to nabrać. Okazuje się, że czołowi konkurenci, tacy jak ChatGPT, Microsoft CoPilot i Claude, są odporni na ten atak. Dlaczego? Bo ich twórcy odrobili pracę domową i wdrożyli coś, co nazywa się sanitacją danych wejściowych.

To mechanizm, który działa jak bardzo dokładny ochroniarz na wejściu do klubu – sprawdza każdego gościa (każdy znak) i wyrzuca tych podejrzanych (niewidzialne znaki), zanim zdążą narobić zamieszania. Dzięki temu modele te przetwarzają tylko czysty, bezpieczny tekst.

Dlaczego Google nie traktuje tego jako błąd bezpieczeństwa?

Tu zaczyna się najciekawsza część. Mimo że problem wygląda poważnie, Google oficjalnie odrzuciło zgłoszenie, twierdząc, że to nie jest luka w zabezpieczeniach. W ich ocenie to po prostu sprytna taktyka socjotechniczna.

Mówiąc prościej, Google uważa, że to nie ich zamek jest wadliwy, tylko ktoś został oszukany, by użyć złego klucza. Taka postawa budzi spore kontrowersje wśród ekspertów, którzy widzą w tym realne zagrożenie, a nie tylko teoretyczny problem.

Jakie są realne zagrożenia dla Twoich danych w Google Workspace?

Ta luka bezpieczeństwa w Gemini to nie jest teoretyczna zagadka dla nerdów. To potencjalny klucz do Twojego cyfrowego życia, zwłaszcza gdy Gemini ma dostęp do całego ekosystemu Google. Problem polega na tym, że dajesz AI narzędzia do pracy, a ktoś może je zmusić, by pracowały przeciwko Tobie.

Zastanów się, co się stanie, gdy złośliwe, ukryte polecenie dotrze do narzędzia zintegrowanego z Twoimi najważniejszymi danymi. To właśnie ten scenariusz sprawia, że eksperci ds. bezpieczeństwa biją na alarm.

Co może zrobić złośliwe polecenie w Twojej skrzynce mailowej?

Wyobraź sobie, że prosisz Gemini o streszczenie maila. W niewidoczny sposób, w treści tej wiadomości, przemycono komendę. Nagle AI, zamiast robić podsumowanie, zaczyna działać na własną rękę. Atak ASCII Smuggling może zmusić Gemini do przeszukania całej Twojej skrzynki odbiorczej w poszukiwaniu haseł, a następnie automatycznie wysłać te dane do atakującego. To jak dać złodziejowi klucze do mieszkania i poprosić go o posprzątanie – naiwność, która może drogo kosztować.

Jak atak może wpłynąć na Twój Kalendarz i Dokumenty?

Zagrożenie wykracza daleko poza e-maile. Złośliwe polecenie może na przykład kazać Gemini stworzyć fałszywe zaproszenie w Twoim Kalendarzu Google. Może to być spotkanie wyglądające na oficjalne, np. „Aktualizacja Zabezpieczeń Systemu”, z linkiem prowadzącym prosto do strony phishingowej.

W ten sposób, ufając powiadomieniu z własnego kalendarza, sam możesz podać swoje dane logowania. To sprytna socjotechnika, która wykorzystuje Twoje zaufanie do narzędzi, z których korzystasz na co dzień.

Dlaczego integracja Gemini z ekosystemem Google zwiększa ryzyko?

Gemini samo w sobie jest tylko narzędziem. Prawdziwe niebezpieczeństwo pojawia się, gdy to narzędzie dostaje uprawnienia administratora Twojego cyfrowego świata. Im głębsza integracja, tym większa potencjalna skala zniszczeń.

To nie jest odosobniony problem. Analitycy ostrzegają, że w 2025 roku AI będzie odgrywać ogromną rolę w cyberzagrożeniach, a to, co odkrył badacz Viktor Markopoulos, jest tego doskonałym przykładem.

Jak chronić się przed atakami ASCII Smuggling w 2025 roku?

OK, koniec straszenia, czas na konkrety. Wiedza o tym, czym jest luka bezpieczeństwa w Gemini, to połowa sukcesu, ale druga połowa to świadome działanie. Ochrona przed takimi atakami to nie czarna magia, a raczej zestaw dobrych nawyków – cyfrowa higiena, o której musisz pamiętać.

Potraktuj to jak zamykanie drzwi na klucz. Niby prosta czynność, ale chroni przed masą kłopotów. Podobnie jest z danymi, które podajesz sztucznej inteligencji.

Praktyczne wskazówki: na co zwracać uwagę w wiadomościach?

Twoja czujność to pierwsza linia obrony. Skoro atak polega na przemycaniu poleceń w niewinnym tekście, musisz traktować każde zewnętrzne dane z ograniczonym zaufaniem. Oto co możesz zrobić:

- Nie ufaj ślepo danym z zewnątrz. Jeśli prosisz Gemini o analizę maila od nieznajomego lub podsumowanie dziwnego dokumentu, zachowaj szczególną ostrożność.

- Weryfikuj źródła aplikacji. Zawsze upewniaj się, że korzystasz z oryginalnej wersji narzędzia. Podrobione aplikacje to prosta droga do utraty danych.

- Pamiętaj o publicznym charakterze promptów. Złota zasada brzmi: wszystko, co wpiszesz w prompcie, potencjalnie może trafić do sieci. Nie wklejaj tam wrażliwych informacji.

Czy warto przejść na bezpieczniejsze alternatywy AI?

Skoro wiemy, że modele takie jak ChatGPT czy Claude są odporne na ten konkretny atak, pytanie nasuwa się samo. Odpowiedź brzmi: to zależy. Jeśli priorytetem jest dla Ciebie maksymalne bezpieczeństwo i nie potrzebujesz głębokiej integracji z ekosystemem Google, alternatywy mogą być rozsądnym wyborem.

Musisz jednak pamiętać, że każdy model ma swoje wady i zalety. Rezygnując z Gemini w Workspace, tracisz wygodę płynnej współpracy między narzędziami. To kompromis między bezpieczeństwem a funkcjonalnością.

Wnioski: Czy sztuczna inteligencja jest bezpieczna dla Twoich danych?

Sztuczna inteligencja jest tak bezpieczna, jak bezpiecznie jej używasz. To potężne narzędzie, ale nie magiczna, nieomylna wyrocznia. Traktuj ją jak stażystę – genialnego, ale wymagającego nadzoru. Nie dawaj mu kluczy do całego królestwa bez odpowiednich zabezpieczeń.

Ostatecznie, korzystając z darmowych narzędzi AI, często płacisz za nie swoimi danymi. Świadomość tego faktu to podstawa, by podejmować mądre decyzje i chronić to, co w cyfrowym świecie najcenniejsze – Twoją prywatność.

--------------------

Źródła:

- https://www.chip.pl/2025/10/luka-w-zabezpieczeniach-gemini

- https://businessinsider.com.pl/technologie/nowe-technologie/sztuczna-inteligencja-powaznym-zagrozeniem-w-2025-r-ostrzega-gigant-technologiczny/enffn16

- https://www.gov.pl/web/baza-wiedzy/pulapki-zwiazane-z-wykorzystywaniem-sztucznej-inteligencji--jak-unikac-zagrozen2

Comments ()