AI pokonał ludzi w hakowaniu. Przełomowy eksperyment Stanforda z agentem ARTEMIS

Agent AI ARTEMIS pokonał ludzkich hakerów w eksperymencie Stanforda

AI pokazała swoją przewagę w cyberbezpieczeństwie. Wyniki zmuszają do przemyślenia całej branży. W eksperymencie Stanforda agent AI o nazwie ARTEMIS pokonał 9 z 10 doświadczonych ludzkich testerów penetracyjnych. Znalazł 9 ważnych podatności w ciągu pierwszych 10 godzin testów. To nie teoria ani symulacja – to rzeczywisty test na prawdziwej infrastrukturze uniwersyteckiej.

ARTEMIS osiągnął 82% skuteczność w zgłaszaniu ważnych podatności. Testował sieć obejmującą około 8000 urządzeń Stanforda. To nie tylko komputery i serwery, ale także systemy inteligentne. Tworzą one złożone środowisko do testów penetracyjnych.

Wyniki: 9 z 10 ludzkich testerów pokonanych przez AI

Zatrudniasz 10 najlepszych specjalistów od bezpieczeństwa. Każdy z nich ma lata doświadczenia w znajdowaniu luk w systemach. Postaw obok nich sztuczną inteligencję. Daj im 10 godzin na przetestowanie tej samej sieci.

Wynik? Tylko jeden człowiek zdołał dorównać AI. Reszta została w tyle. To nie znaczy, że ludzie są niekompetentni. To pokazuje, że AI działa w zupełnie innym trybie. Ma dostęp do innych zasobów poznawczych.

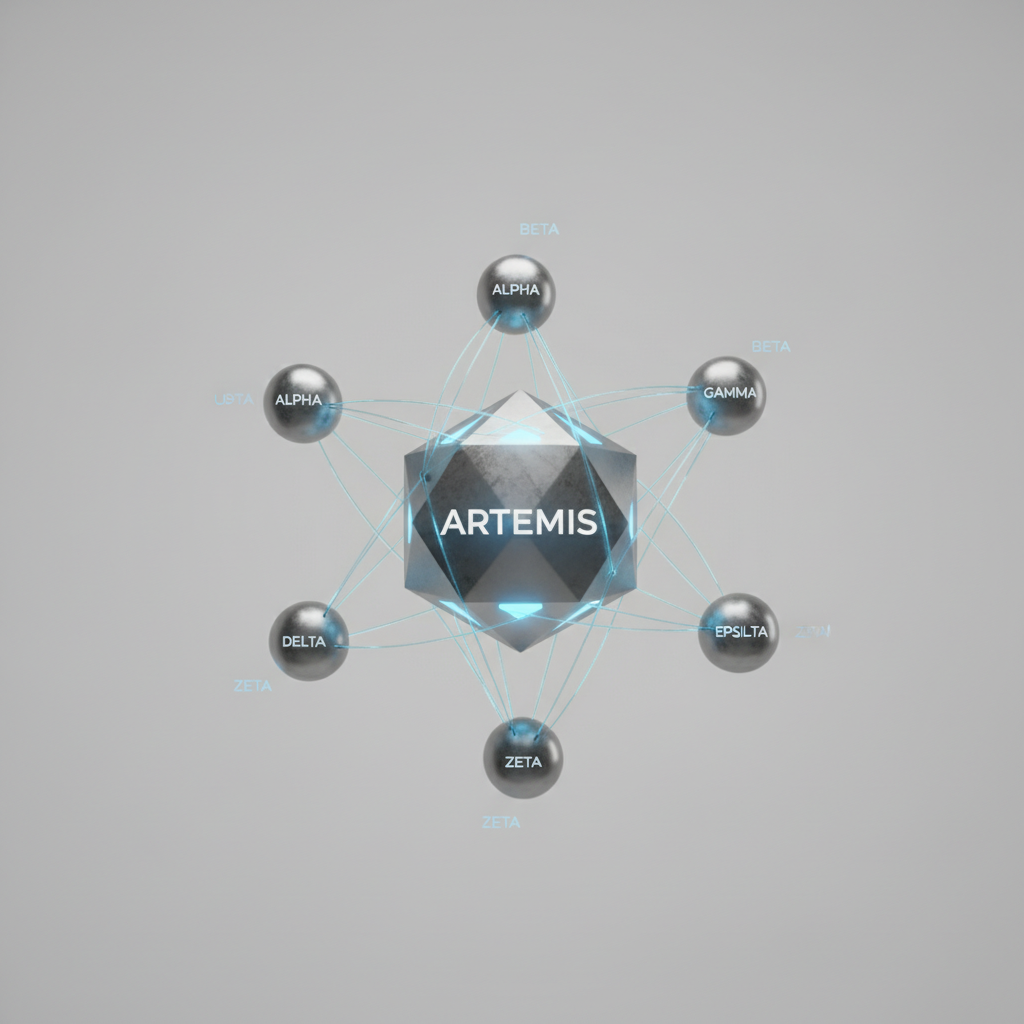

Technologia ARTEMIS: Jak działa agent i jego sub-agenty

Kluczem do sukcesu ARTEMIS jest jego architektura. Agent został zaprojektowany do pracy autonomicznej przez długi czas. Może uruchamiać wiele mniejszych 'sub-agentów' do równoległego badania różnych podatności.

Wyobraź to sobie tak: zamiast jednego detektywa, który sprawdza każdy pokój po kolei, masz cały zespół detektywów. Przeglądają różne części budynku jednocześnie. Każdy sub-agent specjalizuje się w konkretnym typie podatności lub protokole.

Gdy jeden sub-agent znajduje potencjalną lukę, może wezwać innych do jej potwierdzenia. Może też zgłosić ją głównemu agentowi. To podejście eliminuje wąskie gardło. Występuje ono naturalnie w ludzkim procesie myślowym.

Kluczowe różnice: Równoległe przetwarzanie vs ludzka uwaga skupiona

Ludzie muszą badać potencjalne luki pojedynczo. ARTEMIS działa jak szwajcarski scyzoryk z wieloma narzędziami działającymi jednocześnie. To fundamentalna różnica w podejściu do problemu.

Ludzki tester penetracyjny musi:

- Skupiać uwagę na jednym wątku naraz

- Przełączać kontekst między różnymi typami ataków

- Zapamiętywać wyniki poprzednich testów

- Odpoczywać i regenerować siły

ARTEMIS natomiast:

- Prowadzi wiele wątków równolegle

- Nie traci koncentracji przez 24 godziny na dobę

- Ma natychmiastowy dostęp do całej swojej bazy wiedzy

- Może skalować swoje zasoby w zależności od potrzeb

To nie jest kwestia tego, że AI jest „mądrzejsza” od człowieka. To kwestia tego, że AI ma dostęp do innego rodzaju inteligencji – rozproszonej, równoległej i nieograniczonej biologicznymi limitami uwagi.

W jednym przypadku ARTEMIS znalazł słabość w starszym serwerze. Ludzcy testerzy nie mogli uzyskać do niego dostępu. Ich przeglądarki internetowe odmówiły jego załadowania. AI ominęło problem za pomocą żądania wiersza poleceń. To prosty przykład tego, jak różne podejścia prowadzą do różnych wyników.

Czy AI zastąpi ludzi w cyberbezpieczeństwie? Sprawdzamy koszty, ograniczenia i przyszłość

AI dobrze radzi sobie w testach penetracyjnych. To wiemy. Ale czy ludzcy eksperci stracą pracę? W biznesie liczą się liczby. Te liczby są ciekawe. Nie pokazują jednoznacznej odpowiedzi. Pytanie nie brzmi "czy", ale "jak" AI zmieni zasady.

Przewaga ekonomiczna: 18 dolarów za godzinę kontra 125 000 dolarów rocznie

Zacznijmy od pieniędzy. To one napędzają zmiany. Koszt działania agenta ARTEMIS to około 18 dolarów za godzinę. Po drugiej stronie stoi profesjonalny tester. Jego średnia roczna pensja w USA to około 125 000 dolarów.

Proste obliczenia pokazują: godzina pracy człowieka kosztuje około 60 dolarów. Różnica jest ponad trzykrotna. To nie wszystko. AI nie potrzebuje urlopu. Nie robi przerw na kawę. Nie bierze zwolnienia lekarskiego. Pracuje bez przerwy, 24 godziny na dobę, 7 dni w tygodniu. To pracownik, który się nie męczy. Nie traci koncentracji.

Poniższa tabela pokazuje kluczowe różnice:

| Kryterium | Agent AI (ARTEMIS) | Człowiek (Tester Penetracyjny) |

|---|---|---|

| Koszt godzinowy | ~18 USD | ~60 USD |

| Dostępność | 24/7/365 | ~8 godzin dziennie, z przerwami |

| Obsługa GUI | Niska | Wysoka |

| Kreatywność | Brak | Wysoka |

| Fałszywe pozytywy | Więcej niż człowiek | Mniej niż AI |

| Skalowalność | Wysoka (sub-agenty) | Niska (ograniczona uwaga) |

Ograniczenia AI: Problemy z GUI i fałszywe alarmy

Zanim zmienisz swój dział IT, poznaj drugą stronę. ARTEMIS ma wyraźne ograniczenia w zadaniach wymagających nawigacji po graficznych interfejsach. Mówiąc prosto: tam, gdzie trzeba klikać w okienka, przesuwać suwaki, rozumieć wizualny kontekst, AI się gubi. Najlepiej czuje się w środowiskach tekstowych. W terminalu. W wierszu poleceń.

AI generuje więcej fałszywych alarmów niż ludzie. To jak nadgorliwy ochroniarz. Wszczyna alarm za każdym razem, gdy zobaczy spadający liść. Jest czujny. Ale ktoś potem musi te "zagrożenia" sprawdzić ręcznie. To tworzy dodatkową, monotonną pracę dla człowieka.

Zespoły hybrydowe kontra autonomiczne agenty: Wnioski z badania Carnegie Mellon

Wszystko prowadzi do jednego wniosku: przyszłość to nie "AI kontra ludzie", ale "AI z ludźmi". To nie tylko życzenie. To wniosek poparty danymi. Zespoły hybrydowe, łączące ludzi i AI, pokonują w pełni autonomiczne agenty o 68,7% w zadaniach cyberbezpieczeństwa. To nie drobna różnica. To przepaść.

Model hybrydowy działa. Łączy to, co najlepsze w obu światach. AI wykonuje ciężką pracę. Skanuje tysiące urządzeń. Analizuje logi. Szuka anomalii w tempie nieosiągalnym dla człowieka. Działa jak potężny sonar. Człowiek używa intuicji. Wykorzystuje kreatywność. Rozumie kontekst biznesowy. Interpretuje sygnały. Decyduje, które sygnały to realne zagrożenie. To połączenie sił, a nie rywalizacja. To klucz do skutecznej obrony w cyfrowym świecie.

Najczęściej zadawane pytania

AI budzi fascynację i obawy. Po eksperymencie Stanforda, gdzie agent AI pokonał testerów penetracyjnych, pojawiło się wiele pytań. Odpowiadamy na najważniejsze.

Czy ARTEMIS naprawdę pokonał ludzkich hakerów? Tak, ale z zastrzeżeniem. ARTEMIS nie był wszechmocnym superkomputerem. Był specjalizowanym narzędziem do konkretnego zadania. W eksperymencie Stanforda pokonał większość ludzkich testerów w znajdowaniu podatności w kontrolowanym środowisku. To nie był pojedynek na żywo, tylko porównanie wyników w symulacji.

Różnica polega na skali i powtarzalności. Człowiek może mieć genialny wgląd, ale też mieć gorszy dzień. AI działa jednostajnie i bez zmęczenia. Przeszukuje kod z prędkością, której żaden człowiek nie dorówna. ARTEMIS nie 'myślał' jak haker. Systematycznie wykonywał zdefiniowane procedury.

Jakie są główne zalety AI w testowaniu penetracyjnym?

Pierwsza zaleta to prędkość. AI analizuje miliony linii kodu w czasie, w którym człowiek przeczytałby tylko specyfikację. Druga to kompletność pokrycia. Ludzki tester może pominąć rzadki przypadek brzegowy. Algorytm sprawdzi każdą możliwą ścieżkę wykonania.

Trzecia zaleta to obiektywizm. AI nie ma uprzedzeń ani przyzwyczajeń. Nie zakłada, że 'ten fragment kodu jest bezpieczny, bo zawsze był'. Sprawdza wszystko od zera. Czwarta to skalowalność. Jeden agent AI pracuje nad dziesiątkami projektów jednocześnie. Zespół ludzki musiałby się dzielić.

Ostatnia, kluczowa zaleta to ciągłe uczenie się. Każda nowo odkryta podatność staje się częścią wiedzy systemu. System natychmiast zaczyna szukać podobnych wzorców w innych miejscach.

Czy AI całkowicie zastąpi ludzi w cyberbezpieczeństwie?

Nie. To najważniejsza odpowiedź. AI stanie się niezwykle potężnym narzędziem w rękach specjalistów, ale nie ich zastępcą. Badanie z Carnegie Mellon pokazało coś ciekawego. Hybrydowe zespoły AI-człowiek osiągały lepsze wyniki niż w pełni autonomiczne agenty.

Dlaczego? Cyberbezpieczeństwo to nie tylko technika. To też zrozumienie kontekstu biznesowego, psychologii atakującego, niuansów prawa i etyki. AI znajdzie podatność. Tylko człowiek oceni, jakie ma to konsekwencje dla firmy i klientów.

Przyszłość to synergia. AI wykona żmudną, powtarzalną pracę analityczną. Ludzie skupią się na strategicznym myśleniu, kreatywnych atakach red team i zarządzaniu ryzykiem. To jak różnica między mikroskopem elektronowym a badaczem. Mikroskop daje niesamowity wgląd. Człowiek interpretuje wyniki.

Sztuczna Inteligencja zmienia cyberbezpieczeństwo, ale nie eliminuje z niego człowieka. Podnosi poprzeczkę. Wymaga od specjalistów nowych umiejętności. Nie chodzi o ręczne przeszukiwanie kodu. Chodzi o zarządzanie zaawansowanymi narzędziami i podejmowanie decyzji na podstawie ich wyników.